記事の新規公開やリライトをしたら、Googleサーチコンソールで「URL検査」をして、インデックスのリクエストをしますよね。

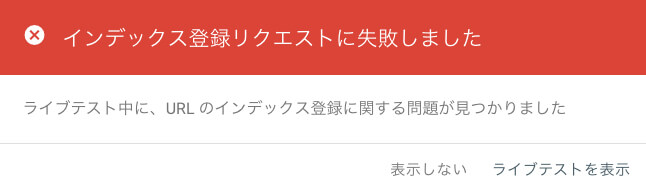

知人のサイトで、以前までできていた「URL検査」が急にできなくなり、以下のエラーメッセージが出るようになっていました。

なかなか対処法が見つからずで困りましたので、この記事で対応策を紹介したいと思います。

上図右下にある「ライブテストを表示」をクリックして、ライブテストの状況を見ても、エラー内容が明記されておらず、特に解決策が見つからない状況でした。

目次

「URL検査」のインデックス登録リクエスト失敗時の状況

まずは、リクエスト失敗時の状況が似ているかどうかを確認ください。

- ライブテストの状況を見ても、「noindex」のエラーは出ていない。

- GoogleサーチコンソールにXMLサイトマップを送信したが、ステータスが「取得できませんでした」になっている。

- WordPressのパーマリンク設定は「基本」の設定(←これはあまり関係なさそうだが)。

「noindex」のエラーが出ている場合は、別の対応策になります。

※「noindex」のエラーが出ている場合の対応策は、別記事にて紹介していきたいと思います。

XMLサイトマップの取得もできていなかったので、Googleのクローラーがはじかれている状況ですよね。

「URL検査」のインデックス登録リクエスト失敗時の対応策

知人のサイトの場合は、以下の「robots.txtを設置する」方法で解決できましたので、みなさんもぜひ試してみてください。

WordPressは「robots.txtにアクセスがあった場合のみ自動生成される」仕組みになっているとのことで、本来は「robots.txt」を設置する必要はないのですが、何かの要因が絡み合って、クローラーが「robots.txt」を読めなくなっているのではないかと思います。

robots.txtの設置方法

「robots.txt」を設置する手順は以下の通りです。

- 「robots.txt」が対象の場所に設置されていないことを確認する(不用意に上書きしないため)。

- 「robots.txt」を作成して、対象の場所に設置する。

- 「https://ドメイン名/robots.txt」にアクセスして、設置状況をチェックする。

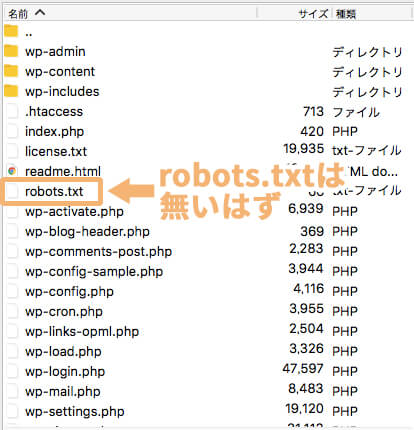

1.「robots.txt」が対象の場所に設置されていないことを確認する

まずは、不用意に上書きしないように、すでに「robots.txt」が設置されていないことを確認します。

FFFTPやFileZillaなどのFTPツールを使用して、WordPressの中身(上図)をチェックしてみてください。

上図ではすでに「robots.txt」が入っていますが、この「robots.txt」がないはずです。

※もし、「robots.txt」がある場合は、記載内容に問題ないかを確認してみてください。

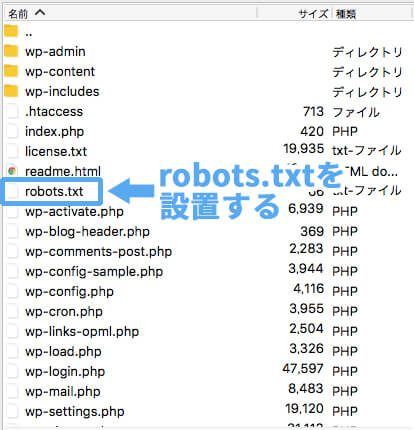

「robots.txt」がないことを確認したら、次は「robots.txt」を作成して、上図の場所に設置します。

2.「robots.txt」を作成して対象の場所に設置する

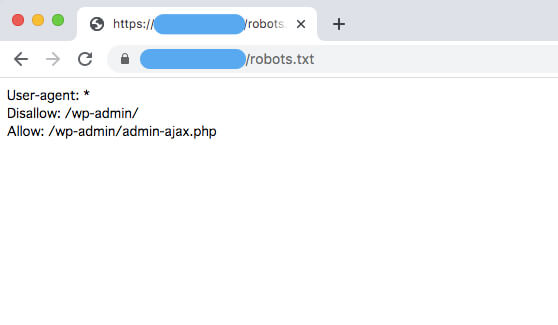

WordPressで自動生成される「robots.txt」の中身は、デフォルトでは以下のようになっています。

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

- 「User-agent」は、対象のクローラーを指定する項目です。「*」を指定すると、全てのクローラーがチェックできるようになります。

- 「Disallow」は、「クロールを許可しない」という意味で、「指定した箇所はクロールしないで」と伝えることができます。

- 「Allow」は、「クロールを許可する」という意味で、「指定した箇所はクロールしてください」と伝えることができます。

この「robots.txt」ファイルをテキストエディタで作成し、FTPツールを使用して、下図の場所に設置しましょう。

※「robots.txt」の「s」を忘れないようにご注意ください。

3.「https://ドメイン名/robots.txt」にアクセスして、設置状況をチェックする

「https://ドメイン名/robots.txt」にアクセスすると、上記で設置した「robots.txt」の内容が表示されると思います。

この表示が確認できれば、対応完了です!

今一度、Googleサーチコンソールで「URL検査」すると、エラーが表示されずに完了できると思います。

まとめ

Googleサーチコンソールの「URL検査」が失敗したときは、「robots.txt」を設置すれば、問題が解決できるかなと思います。

※技術的な解説ができずで申し訳ありませんが……。

「noindex」のエラーが出ている場合は、別の対応方法になります。「noindex」エラーの解決方法については、また別記事にて紹介していきたいと思います。